依據歐盟施行的個人資料保護法,我們致力於保護您的個人資料並提供您對個人資料的掌握。 我們已更新並將定期更新我們的隱私權政策,以遵循該個人資料保護法。請您參照我們最新版的 隱私權聲明。

本網站使用cookies以提供更好的瀏覽體驗。如需了解更多關於本網站如何使用cookies 請按 這裏。

16.03

2025

Edgestar 推論效能實測:Ollama Inference Server 在 Llama3.1、Qwen2.5、Deepseek-r1 的表現

Edgestar 推論效能實測:Ollama Inference Server 在 Llama3.1、Qwen2.5、Deepseek-r1 的表現

隨著大語言模型(LLM)在企業中的應用日益增多,選擇合適的模型對於實現高效能和降低成本至關重要。Spingence推出的Edgestar平台,作為一個高效能的邊緣推論解決方案,能夠幫助企業在本地部署並運行各種LLM模型,確保在不同使用場景中的卓越表現。

本文將深入探討Edgestar平台透過 Ollama Inference Service 在不同語言模型(Llama3.1、Qwen2.5、Deepseek-R1)下的推論效能,並測試其在不同並發請求數量下的表現,讓您了解如何選擇適合的模型來提升您的企業應用。

本文將深入探討Edgestar平台透過 Ollama Inference Service 在不同語言模型(Llama3.1、Qwen2.5、Deepseek-R1)下的推論效能,並測試其在不同並發請求數量下的表現,讓您了解如何選擇適合的模型來提升您的企業應用。

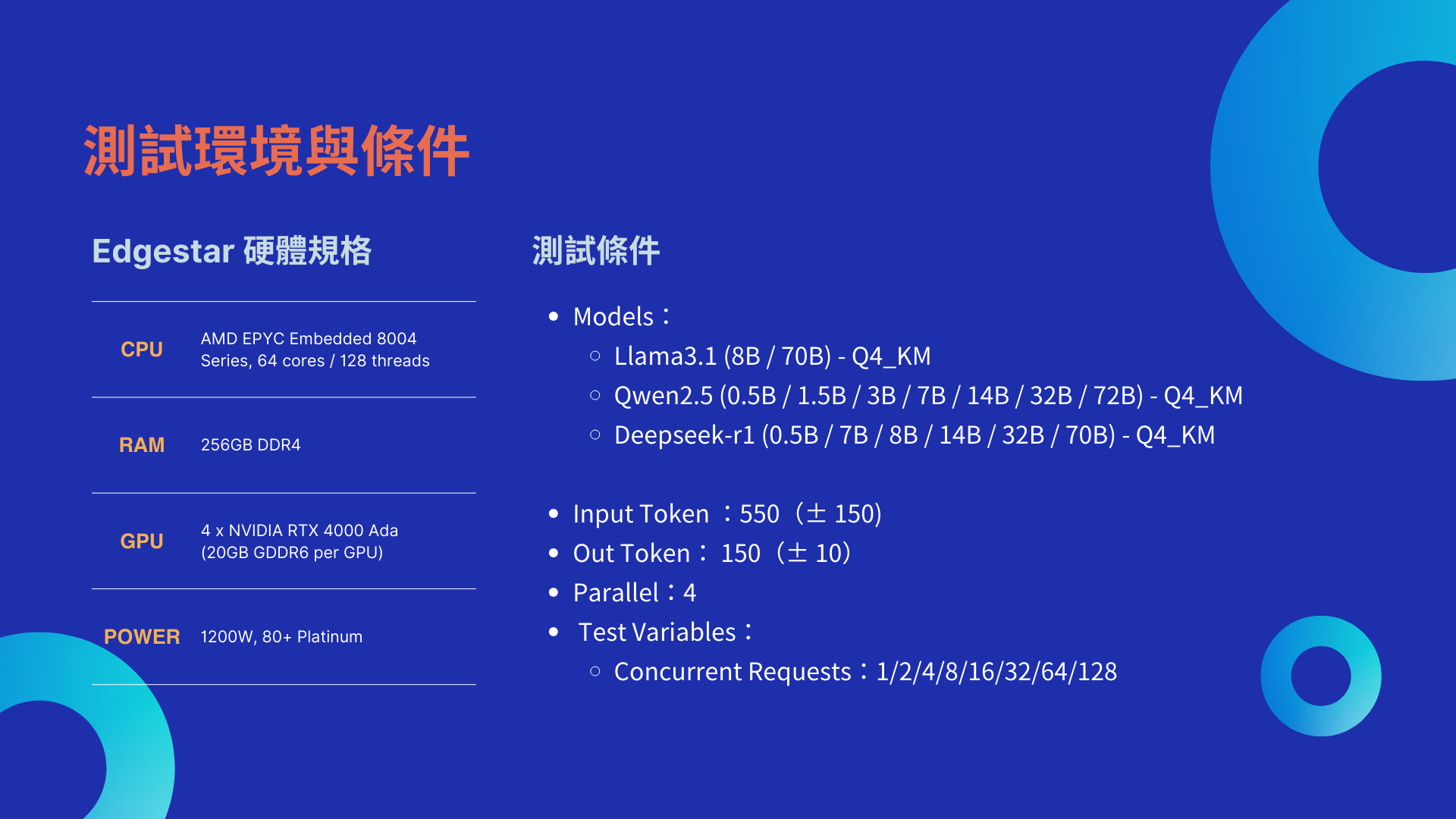

測試環境與條件|

LLM 推論效率指標說明

在進行推論測試時,我們關注三個關鍵效能指標:

- TTFT(Time to First Token):從請求發送到收到第一個 token 的時間,這是衡量模型響應速度的關鍵指標。

- End-to-End Latency:從請求開始到整個推論過程完成所需的總時間,反映了模型的整體處理延遲。

- FPS(Frames Per Second):每秒能處理多少個請求,這是衡量系統處理能力和吞吐量的重要指標。

這些指標有助於評估不同類型的 LLM 在硬體環境下的表現,並了解其在實際應用場景中的運行效率。

單一請求下的 LLM 推論效率

根據模型的參數量級,將 LLM 分為以下三類:輕量化應用(小於 10B 參數)、中量級應用(小於 50B 參數)及重量級應用(大於 70B 參數)。

測試結果顯示,當請求數為 1 時,模型的參數量級對於推論效率有顯著影響。一般而言,輕量化應用的模型在處理單一請求時表現較為迅速,TTFT 和 Latency 較低,TPS 也相對較高。而重量級模型則需要更多的運算資源,表現出較高的 Latency 和較低的 TPS,這是由於更多的參數和更複雜的計算需求所致。

併發請求數變化對 LLM 推論效能的影響

在企業應用中,通常需要處理的並非單一請求,而是來自多個用戶的並發請求。例如,在智能客服系統中,可能會有來自數十個、數百個用戶的並行請求,這要求系統能夠穩定且高效地處理高並發的推論任務。

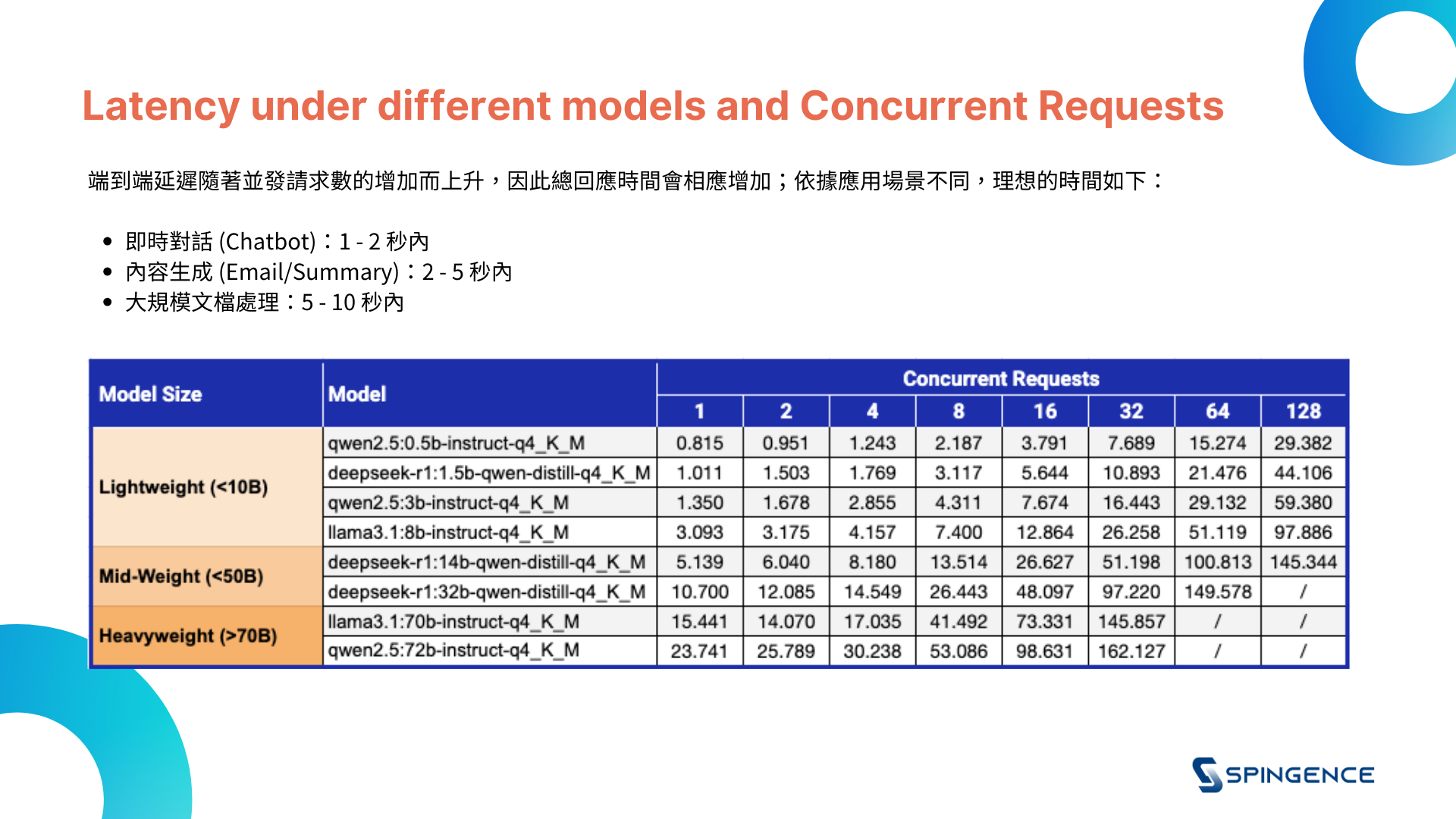

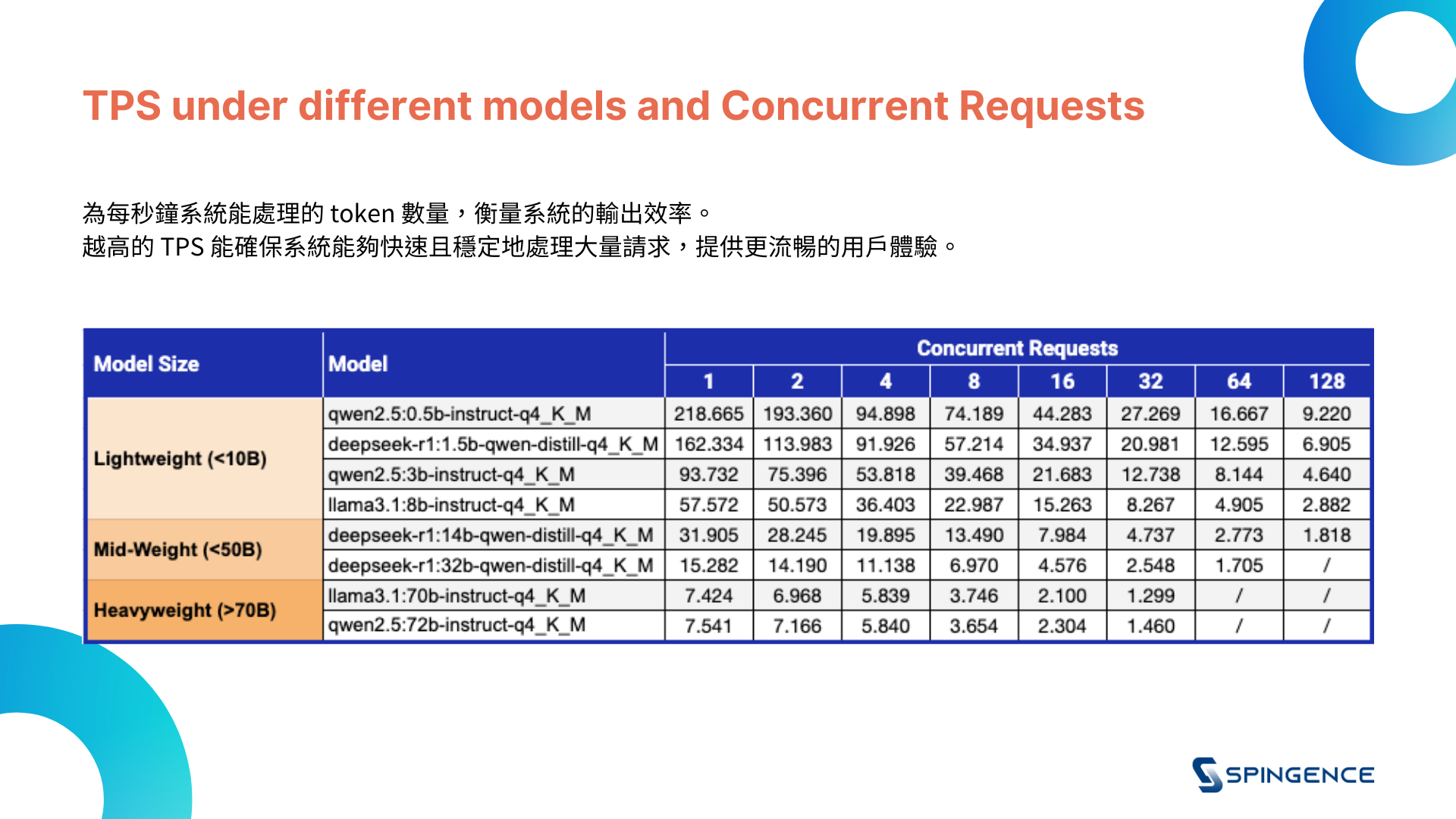

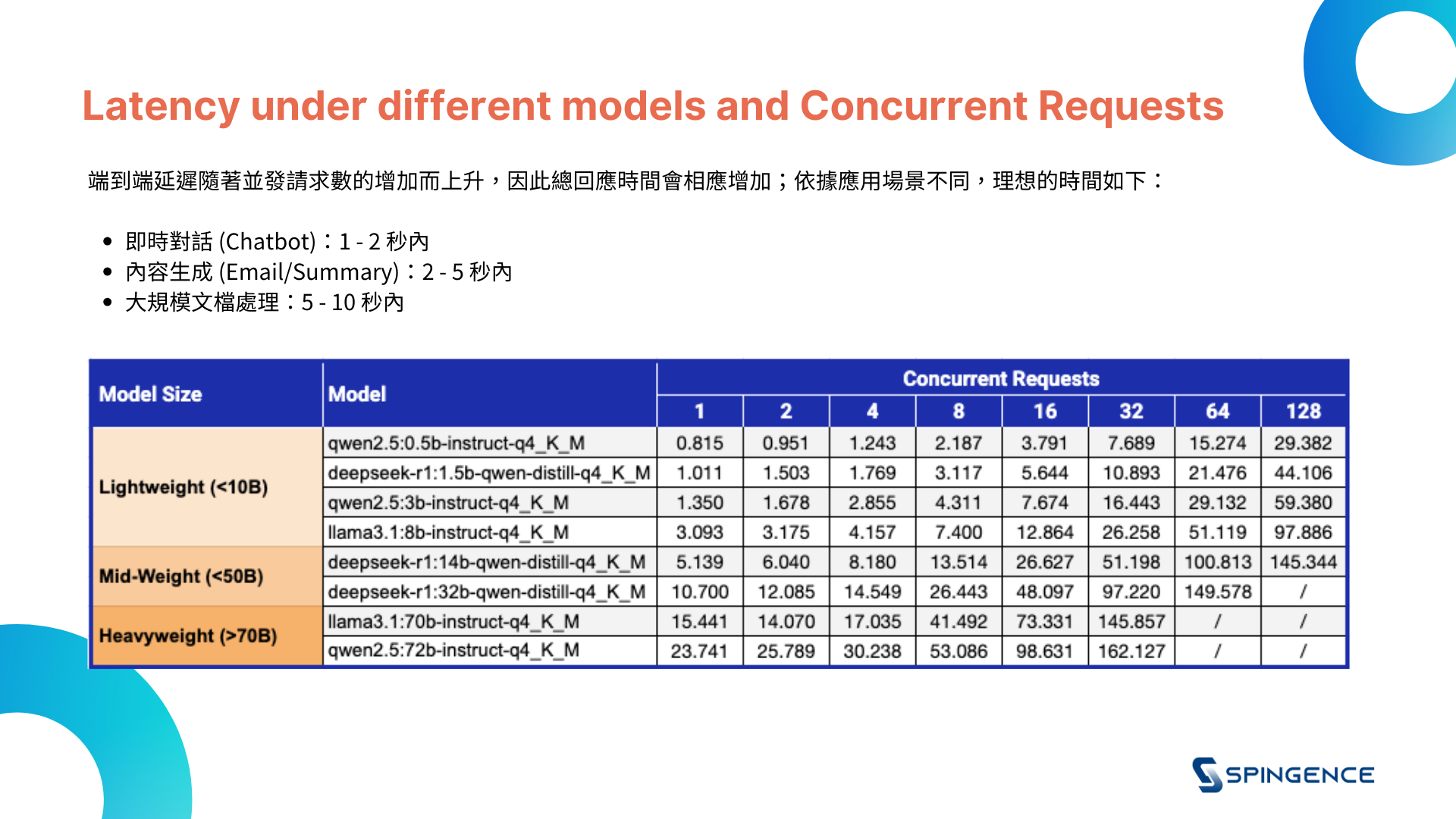

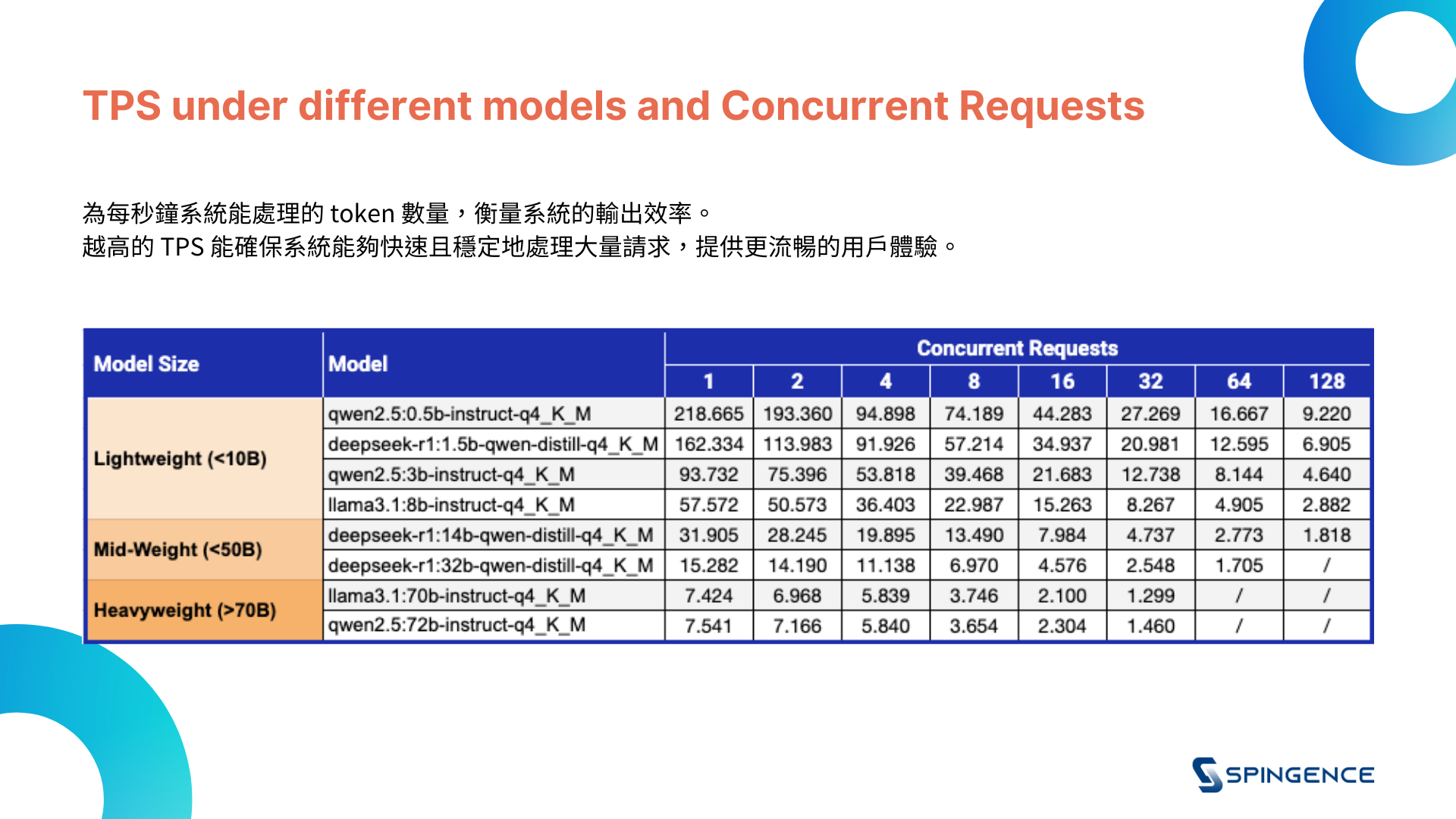

因此,測試中增加了不同並發請求數(1/2/4/8/16/32/64/128),以模擬真實業務環境下的負載情境,並測量每個模型在高負載下的表現。

以下測試結果除揭示了每個模型在不同併發請求下的基礎性能,也對比隨著並發請求數量增加,模型如何應對更高負載。

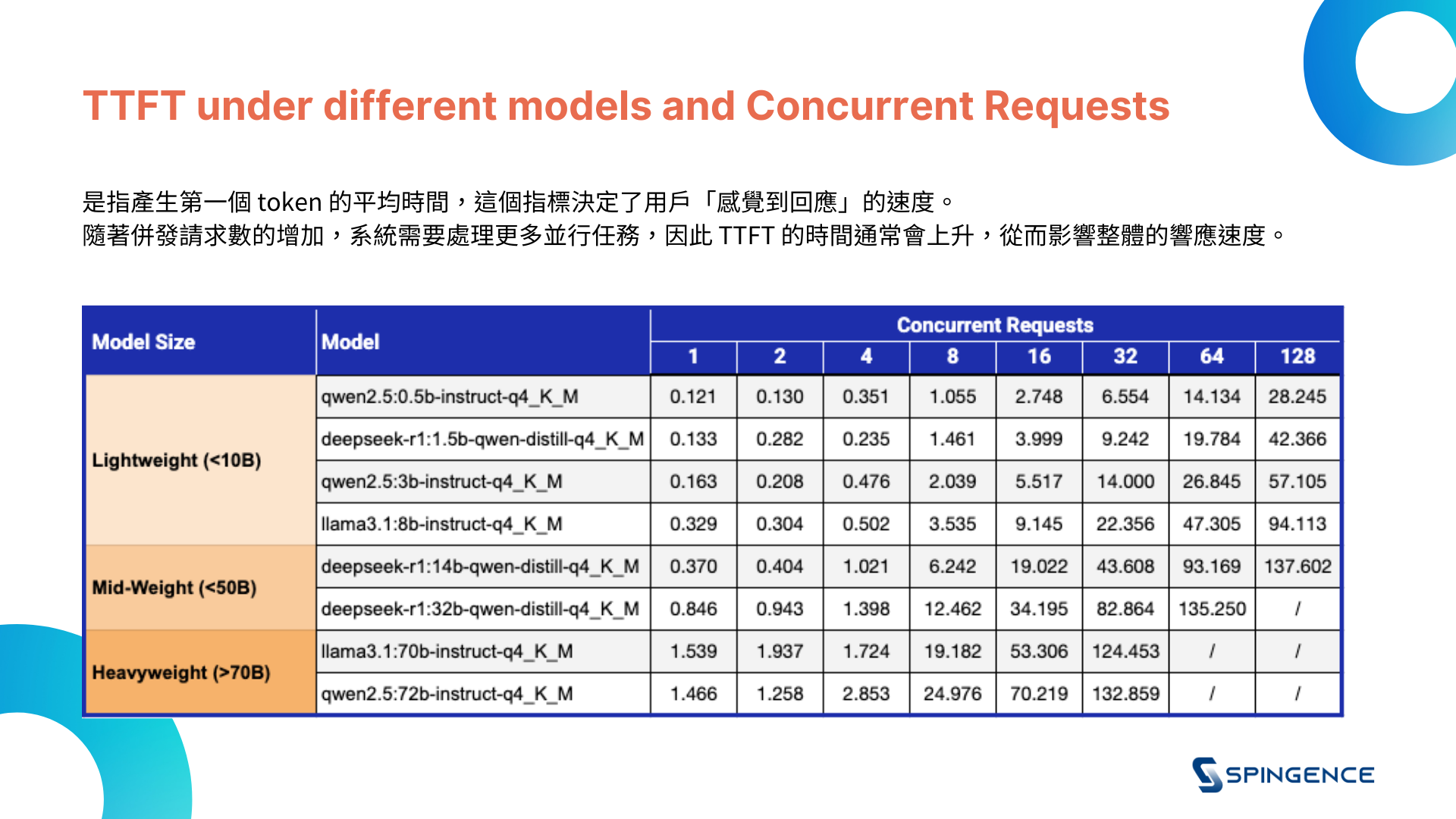

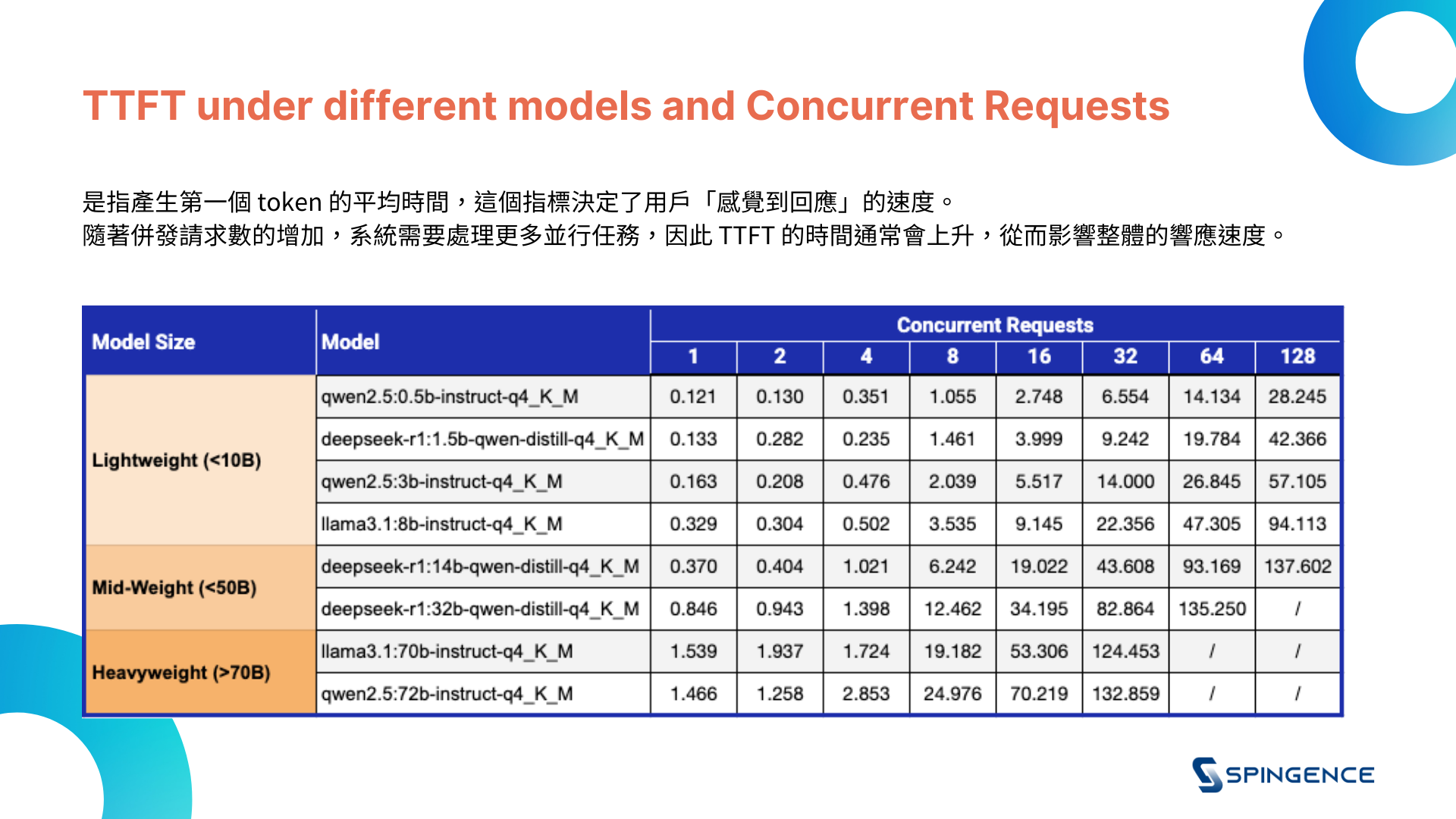

1. TTFT(Time to First Token)

因此,測試中增加了不同並發請求數(1/2/4/8/16/32/64/128),以模擬真實業務環境下的負載情境,並測量每個模型在高負載下的表現。

以下測試結果除揭示了每個模型在不同併發請求下的基礎性能,也對比隨著並發請求數量增加,模型如何應對更高負載。

1. TTFT(Time to First Token)

2. End-to-End Latency

3. Token per Second, TPS

3. Token per Second, TPS

- 輕量化模型(小於 10B 參數):

- 在低請求數量(如 1 和 2 請求)時,輕量化模型的表現十分出色,TTFT 和 Latency 維持在較低水準,且 TPS 表現穩定。

- 當請求數量達到 64 或 128 時,仍能保持較高的 TPS,顯示該類型模型具備較好的擴展性。

- 適合對響應速度有較高要求,且處理並發請求數量較少的應用場景,例如智能客服、基本的文本分類等

- 中量級模型(小於 50B 參數):

- 中量級模型在低請求數量下的表現略低於輕量化模型,但隨著請求數量增加,性能會有所波動。TTFT 和 Latency 有明顯增加,尤其是在 64 和 128 請求數量時,處理能力的下降較為明顯。

- 中量級應用:適用於處理中等複雜度任務,對推論效率有一定要求的場景,例如知識庫查詢、情感分析等。

- 重量級模型(大於 70B 參數):

- 重量級模型的性能在低請求數量下仍然穩定,但隨著請求數量的增加,End-to-End Latency 顯著上升,TTFT 增加,TPS 較低。這類模型較適合處理高並發請求的需求。

- 適合對模型精度要求極高的應用,儘管推論延遲較高,但能提供極為精確的結果,適用於高端數據分析、大規模內容生成等需求。

在企業越來越依賴大語言模型(LLM)進行業務創新的今日,選擇合適的推論解決方案至關重要。

Spingence 的 Edgestar 平台,透過其強大的硬體配置與高效能推論能力,幫助企業在本地部署LLM模型時實現穩定與高效運行,無論面對低並發或高並發的工作負載。

選擇 Edgestar,讓您的企業在大語言模型的應用中取得持續的效能優勢🚀

Spingence 的 Edgestar 平台,透過其強大的硬體配置與高效能推論能力,幫助企業在本地部署LLM模型時實現穩定與高效運行,無論面對低並發或高並發的工作負載。

選擇 Edgestar,讓您的企業在大語言模型的應用中取得持續的效能優勢🚀