依據歐盟施行的個人資料保護法,我們致力於保護您的個人資料並提供您對個人資料的掌握。 我們已更新並將定期更新我們的隱私權政策,以遵循該個人資料保護法。請您參照我們最新版的 隱私權聲明。

本網站使用cookies以提供更好的瀏覽體驗。如需了解更多關於本網站如何使用cookies 請按 這裏。

Keep Spinning

04.12

2024

Fine-Tuning:解鎖 LLM 潛力,為你的企業量身打造專屬 AI 模型

Fine-Tuning:解鎖 LLM 潛力,為你的企業量身打造專屬 AI 模型

在生成式 AI 迅速發展的今天,通用的語言模型(LLM)雖然強大,但往往無法完美契合每個企業的具體需求。如何讓 AI 模型真正發揮專業領域的優勢,並提供精準、可靠的結果?

答案就在於 Fine-Tuning。這項技術能讓你在大規模預訓練模型的基礎上,針對特定領域進行微調,從而大幅提升模型的專業性與準確度。無論是精確的法律分析、醫療診斷還是業務數據解讀,Fine-Tuning 能幫助企業實現從「通用」到「專精」的升級,打造專屬於企業的智慧解決方案。

隨著業務需求的多樣化和專業領域的精細化,Fine-Tuning 不僅是提升模型效能的技術手段,更是推動企業 AI 採用和創新應用的關鍵。

何為 Fine-Tuning?

LLM(大型語言模型)能夠處理各類文本生成任務,如文章撰寫、資料整理等。儘管 LLM 能夠通過提示詞(prompt)生成文章,但其產出的文筆可能無法達到文學家等級的水準。這是因為 LLM 的預訓練過程主要依賴於廣泛且多樣的資料,旨在解決通用的自然語言處理任務,而非針對某一特定領域或風格進行優化。

要讓大型語言模型達到更高的專業水平,就需要運用 Fine-Tuning 技術。這一過程通過讓模型在特定任務或領域的資料上進行微調,能夠讓模型學習並專精於特定領域的語言特徵。舉例來說,娑是我們希望 LLM 生成醫學領域的文章或臨床報告,其專業術語、格式及寫作風格往往與普通文章不同。此時,Fine-Tuning 可以讓模型學習醫學專業知識、語言習慣以及報告的結構,從而生成符合醫學領域要求的文本,並達到高水平的專業品質。

Fine-Tuning 是一種將預訓練的LLM 模型進行微調的技術,以便讓它能夠更好地應對特定的任務或應用場景。這個過程中,我們並不是從頭開始訓練一個新模型,而是利用已經訓練過的模型(通常在大量通用資料上進行過訓練)作為基礎,然後用較小規模、專業性強的資料集對模型進行再訓練。

圖1_透過專業性強的資料集進行微調可以讓 LLM 更好地應對特定的任務圖。資料來源:Spingence 整理製表

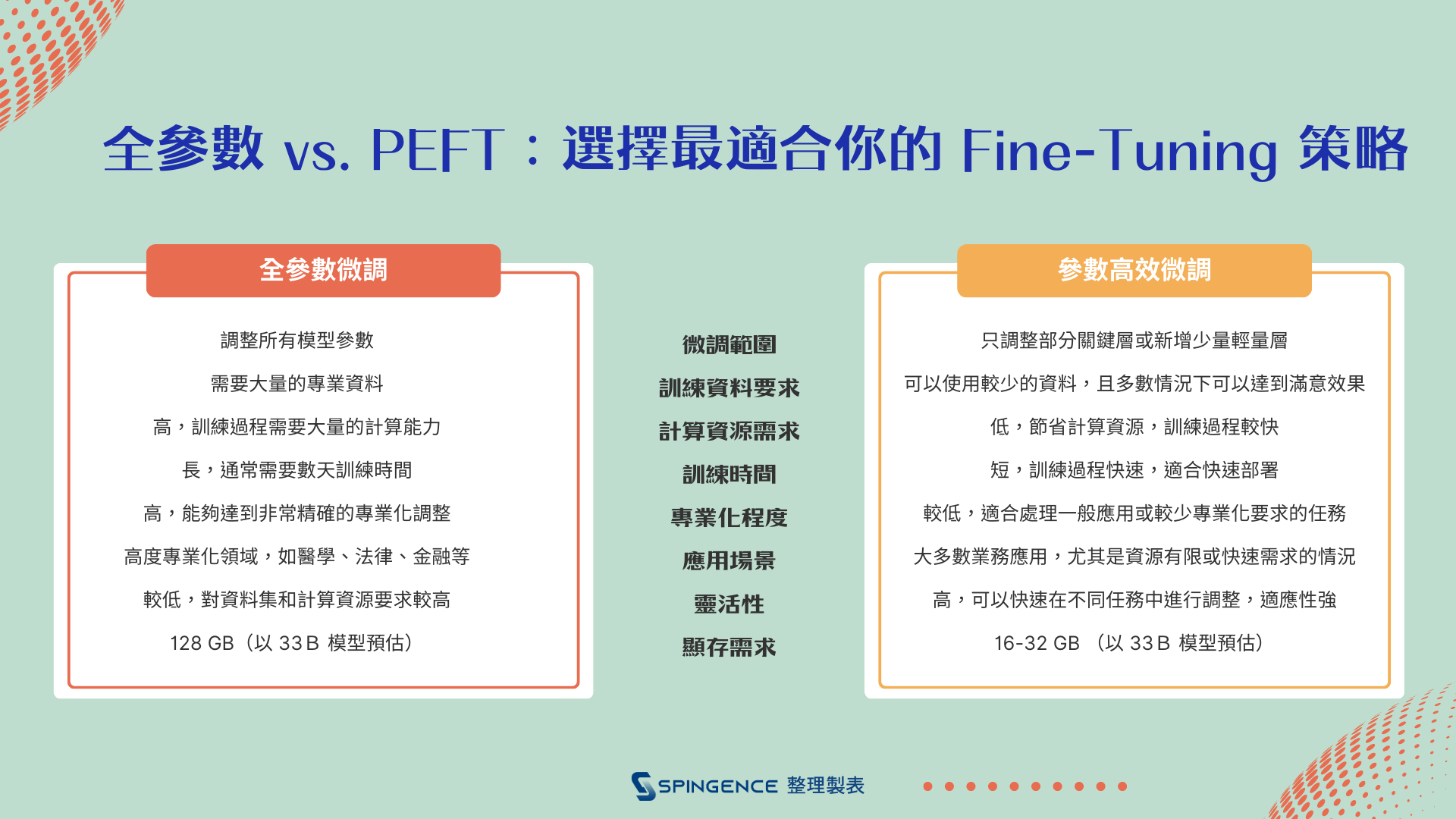

全參數 vs. PEFT:選擇最適合你的 Fine-Tuning 策略

選擇Fine-Tuning 策略時,主要有兩種常見的方式:全參數微調(Full Parameter Fine-Tuning)與 參數高效微調(PEFT, Parameter Efficient Fine-Tuning)。

圖2_全參數微調和參數高效微調(PEFT),都具有其獨特的優勢和挑戰。資料來源:Spingence 整理製表

1. 全參數微調:全面調整,全面提升

全參數微調是指在進行 Fine-Tuning 時,對預訓練模型的所有參數進行調整。這意味著,模型的每一層權重都會根據新的專業資料進行重新訓練。這種方式的最大優點是能夠最大化地將模型調整為最符合特定任務的狀態,通常能夠提供最好的效果,特別是當資料量足夠大且模型的專業性要求很高時。

例如,若我們希望模型能夠處理極為專業的領域知識,像是醫學研究或法律文本,全參數微調能夠提供最佳的結果,確保模型能夠理解並生成符合領域要求的語言。

然而,全參數微調也有其挑戰。這一過程需要大量的計算資源,並且會大幅提高訓練成本。當處理大規模模型(例如 GPT 類型的大型語言模型)時,所需的時間和硬體成本也是不容忽視的。

例如,若我們希望模型能夠處理極為專業的領域知識,像是醫學研究或法律文本,全參數微調能夠提供最佳的結果,確保模型能夠理解並生成符合領域要求的語言。

然而,全參數微調也有其挑戰。這一過程需要大量的計算資源,並且會大幅提高訓練成本。當處理大規模模型(例如 GPT 類型的大型語言模型)時,所需的時間和硬體成本也是不容忽視的。

2. 參數高效微調(PEFT):輕量化選擇,成本效益優先

相比之下,參數高效微調(PEFT)是一種更為精簡的方法,這種方法僅調整模型中少數關鍵層的參數,並保持大部分參數不變。常見的 PEFT 技術包括 Adapter 層、LoRA(Low-Rank Adaptation)等,它們透過在預訓練模型中加入額外的輕量化層來進行微調。這樣的策略不僅大幅減少了需要訓練的參數數量,還能顯著降低訓練的計算成本和時間。

PEFT 的優勢在於其成本效益,特別適合處理資源有限的情況。雖然其在某些情境下可能無法達到全參數微調那樣的高效能,但對於大多數業務應用來說,這樣的微調已經能夠提供足夠的效果。實際應用中,PEFT 通常能夠在較小的資料集上實現較快的調整,並且可在不同的任務中保持較高的表現。

PEFT 的優勢在於其成本效益,特別適合處理資源有限的情況。雖然其在某些情境下可能無法達到全參數微調那樣的高效能,但對於大多數業務應用來說,這樣的微調已經能夠提供足夠的效果。實際應用中,PEFT 通常能夠在較小的資料集上實現較快的調整,並且可在不同的任務中保持較高的表現。

Edgestar:最實惠的 LLM 全參數微調方案

作為完整的 LLM 軟硬整合解決方案,Edgestar 為企業提供高效能與高性價比的全參數微調支援,其優勢包括:

- 高效整合

Edgestar 不僅具備支援 LLM 全參數微調的軟體能力,還內建與 AI 訓練相匹配的硬體資源,包括支援多 GPU 架構與高效存儲方案,使企業能以更低成本部署高效的訓練環境。

- 成本優勢

相較於市場上的其他方案,Edgestar 在性能與成本的平衡上表現卓越。無需耗費高昂資金租用雲端計算資源,企業即可擁有專屬的 LLM 訓練基礎設施,對於企業而言是長期的最佳投資。

- 易用性與靈活性

Edgestar 的軟體提供直觀的用戶界面與自動化流程,降低了全參數微調的技術門檻,即使是缺乏專業 AI 人才的企業也能輕鬆上手。

選擇合適的微調策略,助力企業實現目標

無論是選擇 全參數微調還是 參數高效微調(PEFT),每種 Fine-Tuning 方法都具有其獨特的優勢和挑戰。因此,企業在選擇適合的微調策略時,應綜合考量任務的複雜性、資料量、預算以及計算資源等因素。選擇最合適的 Fine-Tuning 方法,將有助於企業在提升模型效能的同時,實現成本效益的最佳平衡。這不僅能夠提升業務的核心競爭力,更能在激烈的市場競爭中,確保企業在 AI 領域的長期成功。

推薦閱讀:了解Edgestar 硬體規格如何滿足 LLM 全參數 Fine-Tuning